16 خطر هوش مصنوعی که در کمین بشر است!

با گسترش بیسابقهی هوش مصنوعی در انواع صنایع و افزایش نقش آن در زندگی روزمره، بررسی مخاطرات و چالشهای احتمالی این فناوری امری ضروری است. با پیشرفت فوقالعادهی هوش مصنوعی، این فناوری قادر به بهبود بسیاری از جنبههای زندگی است، اما نباید از خطرات ممکن آن غفلت کنیم.

با توجه به اینکه تعداد زیادی از کارشناسان هشدارها و نگرانیهای مرتبط با هوش مصنوعی را مطرح کردهاند، بهتر است بشر به این هشدارها توجه کرده و برای حفظ امنیت و اخلاق در توسعه و استفاده از هوش مصنوعی تدابیر مناسبی اتخاذ کند.

بنابراین، این مسئله نیاز به بررسی دقیقتر و توازن در نگرانیها دارد تا به تعادل مناسبی بین بهرهمندی از فواید هوش مصنوعی و مدیریت خطرات آن برسیم.

1. عدم شفافیت

عدم شفافیت در سیستمهای هوش مصنوعی، بهویژه در مدلهای یادگیری عمیق که میتواند پیچیدگی داشته و تفسیر آنها دشوار باشد، یک مسئله مهم است. این عدم شفافیت فرآیندهای تصمیم گیری و منطق زیربنایی این فناوری ها را مبهم می کند.

وقتی مردم نتوانند درک کنند که یک سیستم هوش مصنوعی چگونه به نتایج خود می رسد، می تواند منجر به بی اعتمادی و مقاومت در برابر پذیرش این فناوری ها شود.

2. تعصب و تبعیض

سیستمهای هوش مصنوعی ممکن است ناخواسته، به دلیل دادههایی که به آنها آموزش داده شده یا به علت طراحی الگوریتمی خاص، تعصبات اجتماعی را ترویج یا تقویت کنند. برای کاهش تبعیض و تضمین عدالت، ضروری است که سرمایهگذاری در توسعه الگوریتمهای بیطرفانه و جمعآوری دادههای آموزشی متنوع صورت گیرد.

3. نگرانیهای حفظ حریم خصوصی

فناوریهای هوش مصنوعی اغلب حجم زیادی از دادههای شخصی را جمعآوری و تجزیه و تحلیل میکنند و این موضوع مسائل مرتبط با حفظ حریم خصوصی و امنیت دادهها را مطرح میکنند.

برای کاهش خطرات حریم خصوصی، ما باید از مقررات سختگیرانه برای حفاظت از دادهها و اتخاذ رویکردهای ایمن در پردازش دادهها استفاده کنیم.

4. معضلات اخلاقی

در سیستمهای هوش مصنوعی، به ویژه در زمینههای تصمیمگیری مهم، معضلات اخلاقی به وجود میآید. القای ارزشهای اخلاقی در این سیستمها چالشهای زیادی ایجاد میکند. محققان و توسعهدهندگان میبایست پیامدهای اخلاقی استفاده از فناوریهای هوش مصنوعی را برای پیشگیری از تأثیرات منفی اجتماعی در نظر داشته باشند.

5. خطرات امنیتی

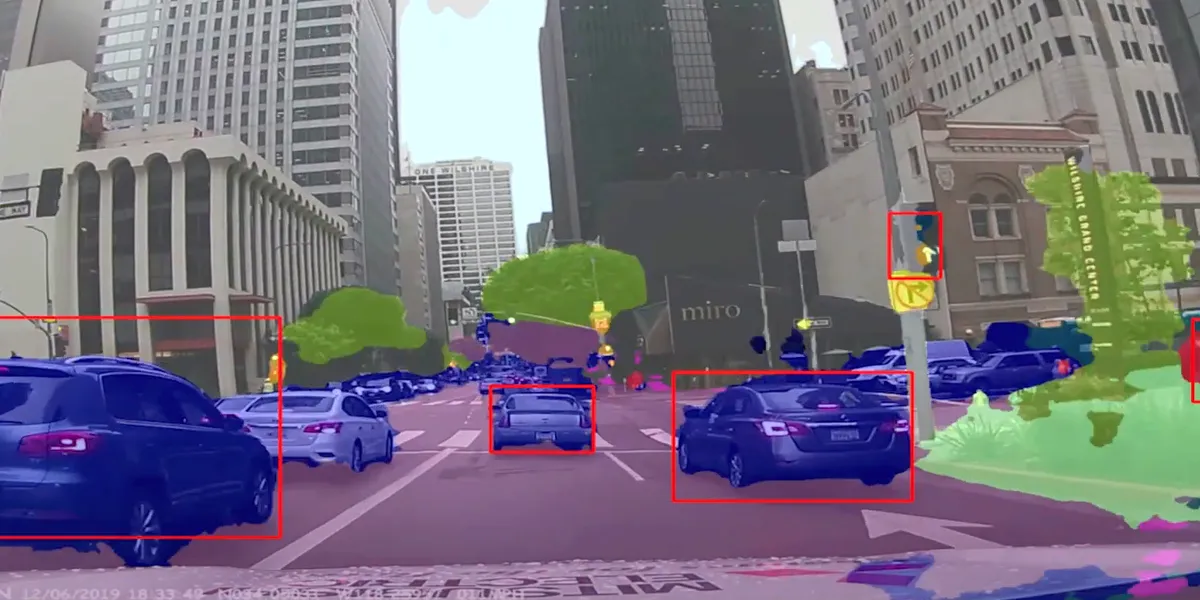

هوش مصنوعی به طور روزافزون در زمینه نفوذ به سیستمهای امنیتی و کسب دسترسی به رمزگذاریهای مختلف تواناتر میشود. این موضوع تا حد زیادی به تطور الگوریتمهای یادگیری ماشینی بازمیگردد. به عبارت دیگر، بدافزارهای مبتنی بر هوش مصنوعی با افزایش تجربه و آزمایش و خطا، تواناییهای بهتری پیدا میکنند و به مرور زمان، تهدید آنها نیز افزایش مییابد.

به علاوه، برخی از فناوریهای هوشمند مانند اتومبیلهای خودران میتوانند اهداف ایدهآلی برای بدافزارهای این چنینی باشند. به عنوان مثال، این بدافزارها ممکن است برای ایجاد تصادفهای رانندگی یا ایجاد ترافیک مسدود در جادهها بهرهبرداری شوند. با تزاحم وابستگیمان به فناوریهای هوشمند متصل به اینترنت، زندگی روزمرهامان به نحوی بیش از پیش در معرض خطر اختلالات قرار میگیرد.

6. سلاحهای خودمختار

سلاحهای خودمختار، به عنوان سیستمهایی که توسط هوش مصنوعی کنترل میشوند و بدون نیاز به دخالت انسان انجام وظایفی را انجام میدهند، مدتهای طولانی است که در حال عملکرد هستند و به عنوان یکی از تهدیدات جدی هوش مصنوعی به انسانها شناخته میشوند. در این راستا، صدها متخصص فناوری با خواستههایی از سازمان ملل متحد برای ایجاد مکانیزمهای حفاظت از بشر در مقابل سلاحهای مستقل از انسان عمل کردهاند.

نیروهای نظامی در کشورهای مختلف در حال حاضر به سلاحهای مبتنی بر هوش مصنوعی یا سلاحهایی که به حدی به این سیستمها وابسته هستند، دسترسی دارند. به عنوان مثال، میتوان به پهپادهای نظامی اشاره کرد که با استفاده از سیستمهای تشخیص چهره میتوانند افراد را با دقت بالا ردیابی کنند.

اما وقتی به الگوریتمهای هوش مصنوعی اجازه داده میشود بدون دخالت انسان در مسائلی مربوط به مرگ و زندگی تصمیم بگیرند، پرسشهای مهمی مطرح میشود. این تواناییها ممکن است تبعاتی وخیم به همراه داشته باشند که نیاز به بررسی دقیق و کنترل مناسب دارند.

7. تمرکز قدرت

تمرکز نیروی کار هوش مصنوعی تحت کنترل تعداد کمی از شرکتها و دولتهای بزرگ میتواند نابرابری را تشدید کرده و تنوع در برنامههای کاربردی هوش مصنوعی را محدود کند. تشویق به توسعه غیرمتمرکز و مشارکتی در زمینه هوش مصنوعی اساسی است تا از تمرکز قدرت جلوگیری شود.

8. وابستگی به هوش مصنوعی

اعتماد بیش از حد به سیستمهای هوش مصنوعی ممکن است منجر به از دست دادن خلاقیت، مهارتهای تفکر انتقادی، و شهود انسانی شود. تعادل بین تصمیمگیری با استفاده از هوش مصنوعی و مشارکت انسانی در حفظ تواناییهای شناختی ما بسیار حیاتی است.

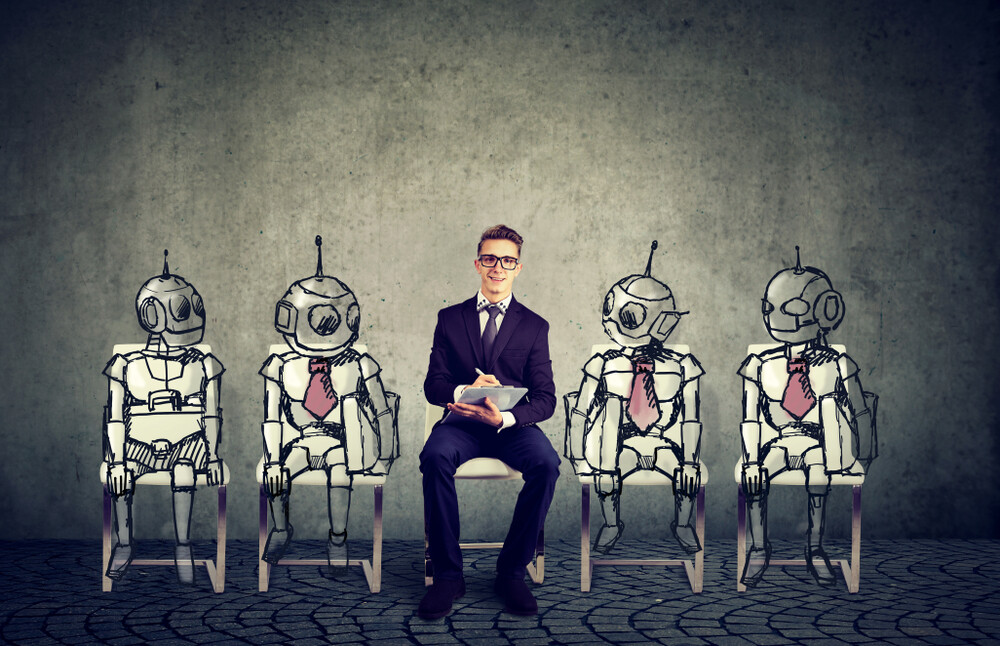

9. از بین رفتن شغل ها

با پیشرفت روزافزون هوش مصنوعی، سیستمهایی به کار گرفته میشوند که تا قبل از این، انسانها وظایف آنها را انجام میدادند. بر اساس گزارشی که توسط سازمان جهانی McKinsey منتشر شده است، تا سال 2030، حدود 800 میلیون شغل در سراسر جهان به خاطر اتوماسیون هوش مصنوعی از بین خواهد رفت. این وضعیت ایجاد یک پرسش بنیادین میکند: چه چیزی برای افرادی که شغل خود را از دست میدهند، در انتظار است؟

بعضی از افراد معتقدند که به دلیل وجود هوش مصنوعی، شغلهای جدیدی به وجود خواهد آمد و بنابراین تعادلی بین شغلهای از دست رفته و شغلهای جدید به وجود خواهد آمد. این افراد اعتقاد دارند که شغلهایی که نیاز به قدرت فیزیکی و انجام وظایف تکراری دارند، جای خود را به شغلهایی با اندیشهگری خلاقانه و تفکر استراتژیک خواهند داد. به همین دلیل، افراد به جای وقت گذراندن در انجام وظایف زمانبر و خستهکننده، وقت بیشتری را برای انجام کارهای مهمتر و بهبود کیفیت زندگی خود و ارتباط با خانواده و دوستانشان خواهند داشت.

10. نابرابری اقتصادی

هوش مصنوعی دارای پتانسیلی است که میتواند به نابرابری اقتصادی با سود نامناسب برای افراد و شرکتهای ثروتمند کمک کند. همانطور که در بالا بحث کردیم، از دست دادن شغلها به دلیل اتوماسیون مبتنی بر هوش مصنوعی بیشتر بر کارگران کم مهارت تأثیر میگذارد و به ایجاد شکاف درآمدی بالا و کاهش فرصتهای تحرک اجتماعی منجر میشود.

سرعت پیشرفت در فناوری هوش مصنوعی، فوق العاده سریع است. اگر برای آن برنامه نداشته باشیم، خطر وقوع یک اتفاق خطرناک در بازه زمانی پنج ساله یا حداکثر 10 ساله، کاملا جدی است.

تمرکز توسعه و مالکیت هوش مصنوعی در تعداد معدودی از شرکتها و دولتهای بزرگ ممکن است این نابرابری را تشدید کند، زیرا آنها ثروت و قدرت را تجمیع میکنند در حالی که کسبوکارهای کوچکتر برای رقابت تلاش میکنند. سیاستها و ابتکاراتی که بر ترویج برابری اقتصادی تمرکز دارند – مانند برنامههای مهارتآموزی مجدد، شبکههای اجتماعی ایمن، و توسعه فراگیر هوش مصنوعی که توزیع متعادلتر فرصتها را تضمین میکند – میتوانند به مبارزه با نابرابری اقتصادی کمک کنند.

11. چالش های قانونی و مقرراتی

ایجاد چارچوب ها و مقررات قانونی جدید برای رسیدگی به مسائل منحصر به فرد ناشی از فناوری های هوش مصنوعی، از جمله مسئولیت و حقوق مالکیت معنوی، بسیار مهم است. سیستمهای حقوقی باید به گونهای تکامل یابند که همگام با پیشرفتهای تکنولوژیک باشند و از حقوق همه محافظت کنند.

12.رقابت مسابقهای در حوزه هوش مصنوعی

خطرات مرتبط با کشورها درگیر شدن در یک مسابقهای در حوزه هوش مصنوعی میتواند به توسعه سریع فناوریهای هوش مصنوعی با پیامدهای پتانسیلی مخرب منجر شود.

اخیراً بیش از هزار تحقیقگر و رهبر فناوری، از جمله مؤسس شرکت اپل، استیو وزنیاک، خواستند که آزمایشگاههای اطلاعاتی توسعه سیستمهای هوش مصنوعی پیشرفته را متوقف کنند. در این نامه آمده است که ابزارهای هوش مصنوعی خطرات عمیقی برای جامعه و بشریت ایجاد میکنند.

در نامه، رهبران اظهار داشتند:

با هوش مصنوعی میتوانیم آیندهای شکوفا داشته باشیم. پس از موفقیت در ایجاد سیستمهای هوش مصنوعی قدرتمند، ما اکنون میتوانیم از تابستان هوش مصنوعی لذت ببریم، این سیستمها را برای بهرهمندی همه افراد مهندسی کنیم و به جامعه فرصتی برای سازگاری با آن بدهیم.

13.از دست دادن ارتباط انسانی

اعتماد بیشتر به ارتباطات و تعاملات مبتنی بر هوش مصنوعی ممکن است منجر به کاهش همدلی، مهارتهای اجتماعی، و ارتباطات انسانی شود. برای حفظ جوهر طبیعت اجتماعی ما، باید به دنبال حفظ تعادل بین فناوری و تعامل انسانی باشیم.

14.دیپفیک و اخبار جعلی

محتواهای تولید شده توسط هوش مصنوعی، مانند دیپفیکها، به گسترش اطلاعات غلط و مخرب در نظر عمومی کمک میکند. تلاشها برای شناسایی و مبارزه با انتشار اطلاعات غلط تولید شده توسط هوش مصنوعی، بسیار حیاتی است تا صداقت اطلاعات در دوران دیجیتال را حفظ کنیم.

محققان دانشگاه استنفورد در یک مطالعه درباره خطرات فوری هوش مصنوعی، اظهار کردند:

سیستمهای هوش مصنوعی در خدمت انتشار اطلاعات غلط در اینترنت قرار میگیرند و این امکان را دارند که به تهدیدی برای دموکراسی و یک ابزار برای فاشیسم تبدیل شوند. از ویدیوهای دیپفیک تا رباتهای آنلاینی که با شبیهسازی توافق عمومی و گسترش اخبار جعلی، خطر از دست دادن اعتماد اجتماعی به وجود میآورند. این فناوری ممکن است توسط مجرمان، دولتهای سرکش، افراطیان ایدئولوژیکی، یا حتی گروههای منافع خاص به منظور دستیابی به منافع اقتصادی یا سیاسی به کار رود.

تکنولوژی دیپفیک روز به روز پیشرفت میکند و تشخیص ویدیوهای مبتنی بر آن به طور چشمگیری دشوارتر میشود. در حال حاضر، این تکنولوژی به طور اساسی برای ساخت ویدیوهای جعلی از افراد مشهور مورد استفاده قرار میگیرد، اما از این پس، کلاهبرداران با استفاده از تصاویر پروفایل افراد معمولی در شبکههای اجتماعی نیز ویدیوهای جعلی از آنها ایجاد میکنند تا تهدیداتی چون باجگیری انجام دهند.

همچنین، استفاده از هوش مصنوعی برای ویرایش تصاویر و تولید صداهای مصنوعی نیز چالشها و اختلافات جدی در جامعه ایجاد میکند. این امر باعث میشود که مضرات استفاده از دیپ فیک به عنوان یکی از ضررهای تکنولوژی هوش مصنوعی مطرح شود.

15.عواقب غیر منتظره

سیستمهای هوش مصنوعی به دلیل پیچیدگی و نداشتن نظارت انسانی ممکن است رفتارهای غیرمنتظرهای از خود نشان دهند که ممکن است منجر به پیامدهای ناخواسته و مخرب برای افراد، شرکتها یا جامعه به طور کلی شود.

استفاده از فرآیندهای دقیق تست، اعتبارسنجی، و نظارت مداوم میتواند به توسعهدهندگان و پژوهشگران در شناسایی و رفع این نوع مشکلات قبل از افزایش آنها کمک کند.

16.خطرات وجودی

توسعه هوش مصنوعی عمومی (AGI) که از هوش انسانی پیشی میگیرد، نگرانیهای بلندمدتی برای بشریت به وجود میآورد. احتمال توسعه AGI میتواند به عواقب ناخواسته فاجعهآمیز منجر شود، زیرا این سیستمهای هوش مصنوعی پیشرفته ممکن است با ارزشها و اولویتهای انسانی همخوانی نداشته باشند.

برای کاهش این خطرات، جامعه پژوهشی در زمینه هوش مصنوعی باید به فعالیتهای تحقیقاتی در زمینه امنیت مشغول شود، در تدوین دستورالعملهای اخلاقی همکاری کند، و در توسعه AGI شفافیت را ترویج دهد. اطمینان حاصل شود که AGI به منافع بهترین برای بشریت خدمت میکند و تهدیدی برای وجود ما ایجاد نمیکند، این امر بسیار حیاتی است.

سخن پایانی

در پایان، هوش مصنوعی به عنوان یکی از بزرگترین پیشرفتهای علمی و فناوری از اهمیت بسیاری برخوردار است، اما همچنان با چالشها و خطرات جدی روبروست. نیاز به توجه به این خطرات و اتخاذ تدابیر مناسب برای مدیریت و کاهش آنها امری بحرانی است. همچنین باید تأکید داشت که هوش مصنوعی با توجه به امکانات بیپایانی که به انسانها ارائه میدهد، پتانسیل بزرگی برای بهبود کیفیت زندگی و حل مشکلات اجتماعی دارد.

با تلاشهای مستمر در زمینه تحقیقات امنیتی، اخلاقی و شفافیت، میتوانیم از خطرات هوش مصنوعی پیشگیری کنیم و از این فناوری بهرهمند شویم. برای آینده بهتری با هوش مصنوعی، همکاری بینالمللی و تعامل میان انسانها و این فناوری ضروری است تا بتوانیم از مزایای آن استفاده کنیم و به شکلی ایمن و عقلانی از آن استفاده نماییم.